23년 7급 인공지능 기출 해설 (20~25번)

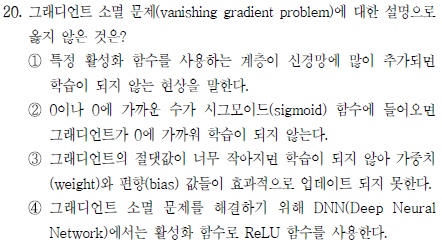

앞서 RNN 문제에서 언급했던 vanishing gradient 문제에 대한 문제다. 사실 그렇게 좋은 문제라고는 생각하지 않는다. 정답은 ②번인데, 왜냐하면 sigmoid 함수의 x=0에 대한 gradient는 0.3이다. 도함수를 그릴 것도 없이 sigmoid 함수를 그려보면 바로 알 수 있는데, x=0 부근에서 기울기가 절대로 0은 아니라는 것을 알 수 있다.

전문가 시스템의 순방향 추론에 대한 문제다. 그냥 글만 읽을 줄 알면 풀 수 있는 문제였으며, 3~4번 규칙에 의해 X, W가 생성되고, 2번 규칙에 의해 Y가 생성되므로 총 3개의 규칙이 추가적으로 생성된다. 따라서 정답은 ③

이 문제는 표준화(Standardization)만 제대로 하면 되는 문제다. 그런데 문제에선 계속 정규화(Normalization)을 얘기해놓고 마지막에 괄호 단서로 표준화하라니.. 이게 무슨 짓인가 싶긴 하다. 어쨌든 문제를 풀어보자. 표준화는 평균과 표준편차를 구해야 한다. 평균은 (40+30+22+24)/4=29이고, 표준편차는 sqrt((121+1+49+25)/4)=7이다.

따라서 24에 대한 표준화 결과는 (24-29)/7 즉 ①번이다.

앞에서 나왔던 CNN 커널 계산 문제의 일반화다. 여태까지 기출에선 스트라이드와 패딩값을 주지는 않아서 쉬웠는데, 이런 변수도 추가적으로 줬다(사실 이 2개 변수를 추가한다 해서 어려울 건 없다). 이때 feature map의 크기를 계산하는 공식은 다음과 같다.

즉, 계산해보면 16×11이고, 답은 ②번이다.

유전 알고리즘까지 나올 줄은 몰랐는데 살짝 놀랐다. 사실 유전 알고리즘이 너무 무작위적이고 대책없는 알고리즘이라 성능도 개판이고 해서 시험에 안나올줄 알았는데..

어쨌든 유전 알고리즘은 실제 DNA의 복제 과정을 그대로 모식한 과정이다. 예를 들어 두 벡터 {1, 0, 1, 0}, {1, 1, 0, 0}가 있다고 할 때, {1, 1, 1, 1}의 값에 가장 가까운 벡터를 찾으려고 한다. 두 벡터로부터 각 요소에서 1개의 값을 임의로 선택하여 자식 벡터로 가져오는데, {1, 0 or 1, 0 or 1, 0} 이런 식의 조합이 가능하다. 그래서 이 자식벡터가 얼마나 {1, 1, 1, 1}에 가까운지 적합도 평가를 하게 되는데, 이 적합도 평가에서 상위 n개 이런 식으로 쳐내서 다음 세대의 유전을 수행한다.

그런데 여기까지만 놓고보면 심해 열수구에서 원시 생명이 생긴 이후 현재에 이르기까지 위대한 생명의 진화를 설명할 수 없다. 바로 돌연변이에 대한 설명이 없기 때문인데, 이것이 바로 mutation이다. 위의 두 벡터로 변이 없이 계속 유전을 돌리면 {1, 1, 1, 0}까지밖에 못 갈뿐 {1, 1, 1, 1}에 도달할 수는 없다. 하지만 이것을 가능하게 하는 것이 바로 mutation이다.

어쨌든 정답은 교차, 변이, 적합도 평가. ③

앞의 VAE 문제에 이어 2번째로 놀란 문제다. 이 문제는 word2vec 모델에 대해 알아야만 풀 수 있다. 주변에 있는 단어를 이용해 중간에 있는 특정 단어를 추론하는 기법은 word2vec 모델의 CBOW에 대한 설명이다. word2vec 모델은 CBOW, skip-gram 기법을 통해 단어의 맥락을 학습하는데, CBOW는 주변 단어로 중심 단어를 추론하는 방식이고, skip-gram은 중심 단어를 통해 주변 단어를 추론하는 방식이다.

통상적으로는 skip-gram의 성능이 더 좋아 skip-gram이 더 많이 쓰인다. 자연어 처리 모델 관련 키워드는 대표적으로 word2vec, transformer, attention mechanism, BERT, GPT, LLM 등이 있다. 현존하는 자연어 처리 모델의 거의 전부는 transformer 모듈에 기반하므로 참고하면 좋다.

5급 문제는 confusion matrix, k-means clustering, 활성화 함수 이렇게 3문제가 출제됐는데, 이 문제에 대한 해설은 다음 포스트에서 할 예정이다.